🗣 SL提问: ai出错的例子

✍️ Ai批改: 人工智能(AI)出错的例子包括但不限于以下几个方面:

1、微软的Tay聊天机器人:2016年,微软发布了一个名为Tay的聊天机器人,旨在通过与用户在Twitter上互动来学习和改进。然而,这个实验很快出了问题。恶意用户教Tay学习并重复了一些种族主义和性别歧视的短语,导致Tay发布了许多有争议和冒犯性的推文。微软迅速关闭了Tay的账户,以防止进一步的损害。

2、谷歌图像识别错误:2015年,谷歌的图像识别AI将非洲裔美国人错误地识别为“大猩猩”。这一错误凸显了AI在识别和分类图像时的偏见和缺陷,可能导致误解和不准确的表示。

3、亚马逊的招聘工具歧视女性:2018年,有报道称亚马逊开发的AI招聘工具歧视女性。该工具根据过去的招聘数据进行训练,反映出科技行业男性主导的历史,因此它更倾向于为男性候选人打高分,而对女性候选人则给予较低的评分。亚马逊最终停止了这个工具的使用。

4、自动驾驶汽车事故:2018年,一辆Uber自动驾驶汽车在亚利桑那州发生致命车祸,撞死了一名行人。这起事故凸显了自动驾驶汽车在复杂、不可预测的现实世界环境中应对边缘情况的挑战。

5、面部识别错误:许多面部识别系统已经被证明在识别皮肤颜色较深的人脸时存在不准确性,这可能导致错误识别、误捕或漏捕。这在执法和其他高风险应用中引发了对公平性和正义性的担忧。

6、医疗诊断错误:AI在医疗诊断中的应用虽然前景广阔,但也出现了错误。例如,某些AI系统在分析医疗图像(如X光片和MRI扫描)时,可能会由于训练数据不足或偏差而产生误诊。

7、Deepfake伪造视频和音频:AI生成的“Deepfake”视频和音频内容可以极为逼真地伪造人们的脸部、声音甚至行为。然而,它们被用于传播虚假信息、诈骗甚至伪造证据,对社会和政治稳定构成威胁。

8、自动驾驶汽车的路标误判:在测试中,一些自动驾驶汽车的AI系统错误地解读了道路标志,导致车辆在现实世界中可能无法正确响应交通信号。

9、预测性警务的偏见:一些用于预测犯罪可能性的AI系统被发现存在偏见,它们更倾向于关注某些社区或人群,可能是因为它们的数据训练集存在历史偏见。

10、金融交易错误:AI系统在金融服务中用于检测欺诈和做出交易决策。然而,如果这些系统没有得到适当的训练或监控,它们可能会错误地标记合法交易为欺诈,或者反之亦然,导致不便或经济损失。

这些例子说明了AI出错的多种方式,强调了在开发、部署和监控AI系统时需要仔细考虑伦理、偏见和准确性。

0

IP地址: 10.191.167.4

搜索次数: 0

提问时间: 2025-04-20 15:46:42

❓️ 热门提问:

超火ai

黄金回收价格根据什么定的

2023年今日回收黄金的价格

换黄金首饰划算吗

外汇大厦

购动车票官网

ai制图网站免费

金戒指断了

工信

100克金条出售多少钱

豌豆Ai站群搜索引擎系统

🤝 关于我们:

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

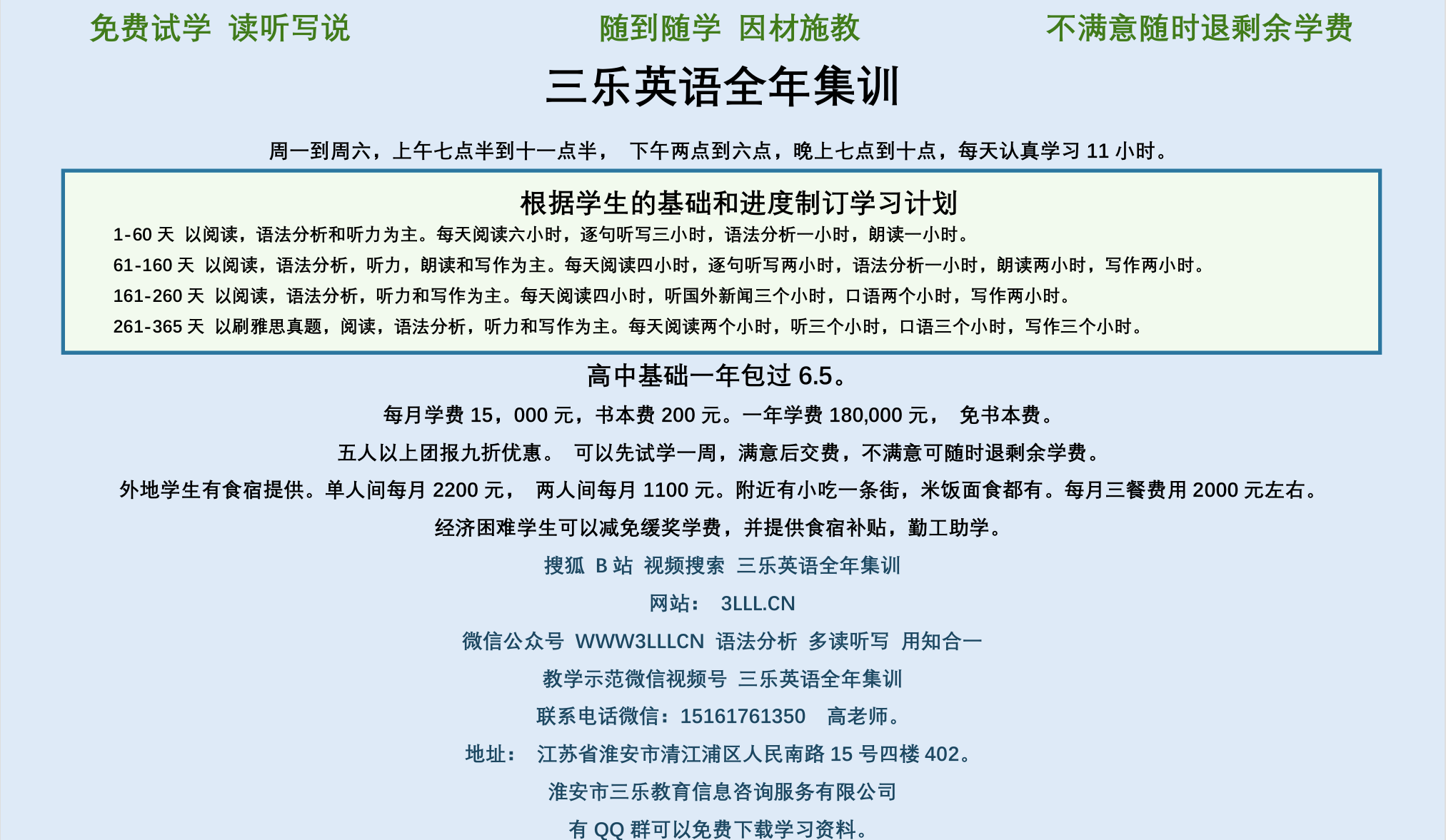

英语培训

本站流量

联系我们

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。